회사에서는 ECS Anywhere를 사용중이며 컨테이너의 로그는 NAS와 마운트된 디렉토리를 볼륨 마운트로 해당 디렉토리에 로그를 적재 하고 있다. IDC → AWS로 이관한다면 NAS는 동일하게 사용할 수 없으므로 firelens를 사용해 S3에 로그를 저장하는 방법이 있다.

1. ECS firelens란

FireLens는 AWS에서 제공하는 컨테이너 로그 라우팅 및 수집 기능이다. ECS(Elastic Container Service)와 EKS(Kubernetes Service)에서 사용할 수 있으며, Fluent Bit과 Fluentd를 사용하여 로그를 다양한 대상(예: Amazon CloudWatch, Amazon S3, Amazon Kinesis Data Firehose, Elasticsearch 등)으로 라우팅할 수 있다.

주요 기능 및 이점

- 다양한 로그 대상 지원: FireLens는 로그를 다양한 대상에 라우팅할 수 있어, 애플리케이션 로그를 필요한 곳으로 손쉽게 전송할 수 있다.

- 간단한 설정: FireLens를 사용하면 로그 수집기를 컨테이너 이미지에 포함시키지 않고도 로그를 라우팅할 수 있다. 이는 ECS/EKS 작업 정의에서 간단한 설정으로 이루진다.

- 유연한 설정 파일: Fluent Bit과 Fluentd의 강력한 기능을 활용하여 로그 라우팅, 필터링, 변환 등을 자유롭게 설정할 수 있다.

- 일관된 로그 관리: FireLens를 사용하면 애플리케이션 로그를 중앙 집중화하고 일관되게 관리할 수 있어, 로그 분석과 모니터링을 더 효과적으로 할 수 있다.

2. 작업정의

Firelens는 로그를 수집할 컨테이너와 함께 사이드카 패턴으로 컨테이너를 띄우게된다. 여기서는 fluent-bit를 사용한다

- Fluent Bit은 로그를 버퍼링하고, 컨테이너 종료 전에 남아있는 로그를 모두 전송한다.

- AWS ECS에서 stopTimeout을 설정하여 컨테이너가 종료되기 전에 충분한 시간을 확보할 수 있다.

- 이러한 설정을 통해 컨테이너가 종료되더라도 로그 손실을 최소화할 수 있다.

{

"name": "python-test",

"image": "테스트용 이미지",

"cpu": 0,

"memory": 2048,

"portMappings": [

{

"containerPort": 8080,

"hostPort": 0,

"protocol": "tcp"

}

],

"essential": true,

"environment": [

{

"name": "TG_ARN",

"value": "타겟그룹 ARN"

}

],

"mountPoints": [

{

"sourceVolume": "common",

"containerPath": "/opt/ecs/common/",

"readOnly": true

}

],

"volumesFrom": [],

"linuxParameters": {

"initProcessEnabled": true

},

"stopTimeout": 150,

"logConfiguration": {

"logDriver": "awsfirelens",

"options": {

"bucket": "<테스트용 S3 버킷>",

"store_dir": "/tmp/fluent-bit/s3",

"static_file_path": "On",

"s3_key_format": "/test-logs/%Y/%m/%d/%H/${HOSTNAME}_%Y_%m_%d_%H_%M.gz",

"use_put_object": "On",

"upload_timeout": "10m",

"compression": "gzip",

"region": "ap-northeast-2",

"Match": "*",

"Name": "s3"

}

},

"systemControls": []

},

{

"name": "log_router",

"image": "public.ecr.aws/aws-observability/aws-for-fluent-bit:stable",

"cpu": 0,

"memoryReservation": 50,

"portMappings": [],

"essential": true,

"environment": [],

"mountPoints": [],

"volumesFrom": [],

"user": "0",

"systemControls": [],

"firelensConfiguration": {

"type": "fluentbit",

"options": {

"enable-ecs-log-metadata": "false"

}

}

}

2.1. python-test 컨테이너의 logConfiguration

"logConfiguration": {

"logDriver": "awsfirelens",

"options": {

"bucket": "<테스트용 버캇>",

"store_dir": "/tmp/fluent-bit/s3",

"static_file_path": "On",

"s3_key_format": "/test-logs/%Y/%m/%d/%H/${HOSTNAME}_%Y_%m_%d_%H_%M.gz",

"use_put_object": "On",

"upload_timeout": "10m",

"compression": "gzip",

"region": "ap-northeast-2",

"Match": "*",

"Name": "s3"

}

}- logDriver: awsfirelens – FireLens 로그 드라이버를 사용한다.

사용한 옵션은 아래와 같다.

- bucket: mh-test-s3 – 로그를 저장할 S3 버킷의 이름

- store_dir: /tmp/fluent-bit/s3 – 로그를 임시로 저장할 경로

- store_dir 옵션은 Fluent Bit이 로그 파일을 임시로 저장할 로컬 디렉토리를 지정한다. 이 옵션은 FireLens를 통해 S3와 같은 외부 스토리지에 로그를 업로드하기 전에 잠시 동안 로그 파일을 로컬에 저장할 위치를 지정하는 데 사용된다.

- static_file_path: On – static_file_path 옵션이 On으로 설정되면, S3 키 이름에 UUID 문자열이 자동으로 추가되는 것을비활성화한다.

- 기본 동작 (Off)

- UUID 추가: 기본적으로, S3에 로그 파일을 업로드할 때, 경로(s3_key_format)에 $UUID 변수를 포함하지 않으면 시스템이 자동으로 UUID 문자열을 추가한다. 이는 파일 이름의 고유성을 보장하기 위함이다.

- 예제: s3_key_format이 /test-logs/%Y/%m/%d/%H/%M.gz로 설정되어 있는 경우, 업로드된 파일의 실제 경로는 /test-logs/2024/07/30/15/30_abcd1234-ef56-7890-gh12-ijkl3456mnop.gz와 같이 UUID가 추가된다.

- UUID 비활성화: static_file_path를 On으로 설정하면, UUID가 자동으로 추가되지 않는다. 대신, 지정한 경로 형식 그대로 파일이 저장된다.

- 예제: s3_key_format이 /test-logs/%Y/%m/%d/%H/%M.gz로 설정되어 있고, static_file_path가 On으로 설정된 경우, 업로드된 파일의 실제 경로는 /test-logs/2024/07/30/15/30.gz가 된다.

- 기본 동작 (Off)

- s3_key_format: /test-logs/%Y/%m/%d/%H/${HOSTNAME}_%Y_%m_%d_%H_%M.gz – S3 버킷 내에서 로그 파일이 저장될 경로 형식이다. 날짜와 호스트 이름을 포함하여 로그 파일을 구조화한다.

- use_put_object

- On: PUT 요청을 사용하여 개별 파일에 대한 세부 설정이 가능하고, 작은 파일 업로드에 적합하다.

- Off: Multipart Upload를 사용하여 대용량 파일을 효율적으로 업로드하고, 네트워크 오류 시 유연하게 재시도할 수 있다.

- upload_timeout: 10m – 로그 업로드 타임아웃 설정

- compression: gzip – 로그 파일을 gzip으로 압축

- compression 옵션은 use_put_object 옵션이 On or Off 일때만 사용이 가능하며 현재 gzip만 제공하고있다.

- region: ap-northeast-2 – S3 버킷이 위치한 AWS 리전

- Match: * – 모든 로그를 매칭하여 처리

- Name: s3 – 로그를 S3로 전송하도록 설정

2.2. log_router 컨테이너의 firelensConfiguration

{

"Version": "2012-10-17",

"Statement": [{

"Effect": "Allow",

"Action": [

"s3:PutObject"

],

"Resource": "*"

}]

}

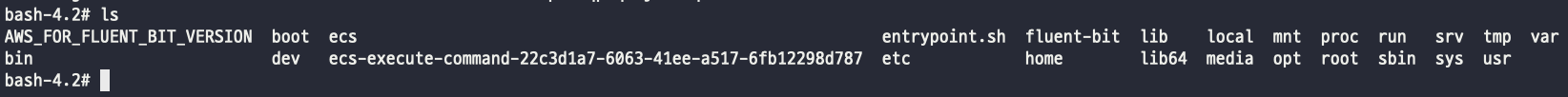

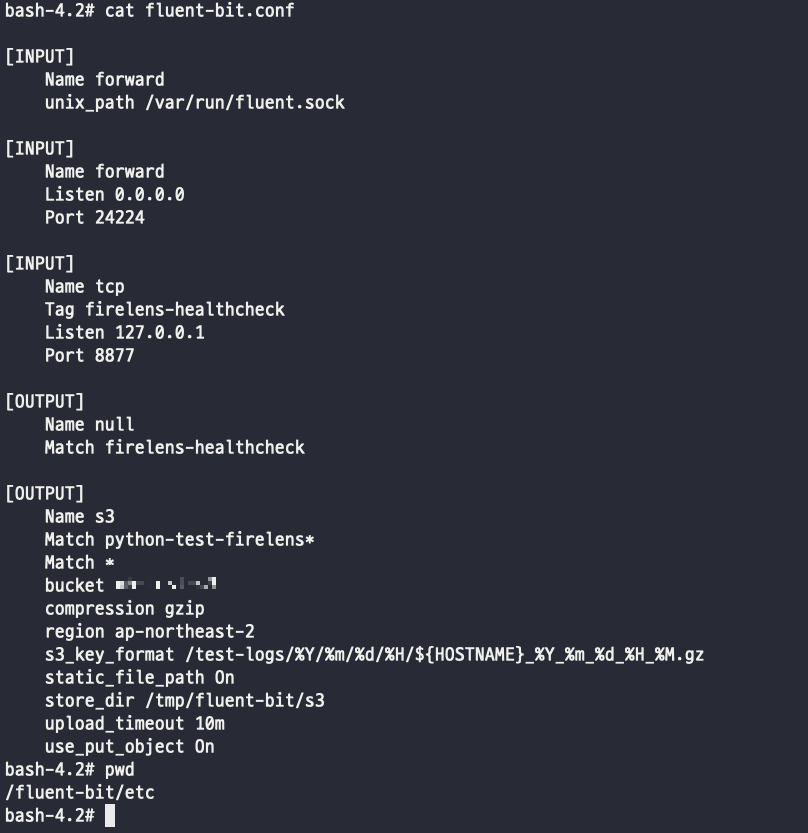

3. Fluent-bit conf

작업정의에 세팅 했을때

fluent-bit 컨테이너 내부에 접근하게 되었을때 아래와 같이 확인이 가능하다.

fluent-bit 컨테이너를 사이드카로 띄우고 옵션 설정을 작업정의에 세팅 한다면 컨테이너 내부 /fluent-bit/etc 경로에의 fluent-bit.conf 파일에 오버라이드 된다.

3.1. 직접 커스텀한 conf 사용

커스텀한 conf를 사용하는 방법은 file, S3 두가지 방법이 존재한다.

꼭 확인해야할 사항은 fluent-bit 관련 옵션은 꼭 로그를 만들어내는 어플리케이션 컨테이너 정의에 설정해야한다.

file 방법

AWS에서 제공한 fluent-bit 이미지를 커스텀한 conf 파일로 빌드해서 사용이 가능하다. 예시는 아래와 같다.

# AWS에서 제공하는 Fluent Bit 이미지 사용

FROM public.ecr.aws/aws-observability/aws-for-fluent-bit:stable

# 필요한 디렉토리를 생성

RUN mkdir -p /fluent-bit/config /tmp/fluent-bit/s3

# Fluent Bit 설정 파일을 컨테이너에 복사

COPY fluent-bit.conf /fluent-bit/config/

# Fluent Bit을 포그라운드에서 실행하여 로그를 출력

CMD ["/fluent-bit/bin/fluent-bit", "-c", "/fluent-bit/config/fluent-bit.conf"]

복사할 conf

[INPUT]

Name forward

unix_path /var/run/fluent.sock

[INPUT]

Name forward

Listen 0.0.0.0

Port 24224

[INPUT]

Name tcp

Tag firelens-healthcheck

Listen 127.0.0.1

Port 8877

[OUTPUT]

Name null

Match firelens-healthcheck

[OUTPUT]

Name s3

Match *

bucket 버킷

compression gzip

region ap-northeast-2

s3_key_format /test-logs/%Y/%m/%d/%H/${HOSTNAME}_%Y_%m_%d_%H_%M.gz

static_file_path On

store_dir /tmp/fluent-bit/s3

upload_timeout 10m

use_put_object On

위의 방식으로 빌드된 fluent-bit 파일을 사용한다면 아래와 같다.

{

"family": "my-task",

"taskRoleArn": "arn:aws:iam::123456789012:role/my-task-role",

"executionRoleArn": "arn:aws:iam::123456789012:role/my-execution-role",

"containerDefinitions": [

{

"name": "my-application",

"image": "my-application-image",

"logConfiguration": {

"logDriver": "awsfirelens",

"options": {

"Name": "firelens",

"config-file-type": "file",

"config-file-value": "/fluent-bit/config/fluent-bit.conf"

}

}

}

]

}

만약에 해당 conf 파일 하나로 여러 컨테이너에서 사용하고 싶다면 환경변수로 내부 옵션에 설정도 가능하다.

[OUTPUT]

Name s3

Match *

bucket ${BUCKET_NAME}

compression gzip

region ap-northeast-2

s3_key_format /${SERVICE_NAME}/%Y/%m/%d/%H/${HOSTNAME}_%Y_%m_%d_%H_%M.gz

static_file_path On

store_dir /tmp/fluent-bit/s3

upload_timeout 10m

use_put_object On

위와 같이 변수로 처리 하고 이미지를 생성했다면 해당 작업정의로 사용이 가능하다.

{

"name": "python-test",

"image": "테스트 이미지",

"cpu": 0,

"memory": 2048,

"portMappings": [

{

"containerPort": 8080,

"hostPort": 0,

"protocol": "tcp"

}

],

"essential": true,

"environment": [

{

"name": "TG_ARN",

"value": "타겟그룹 ARN"

}

],

"mountPoints": [

{

"sourceVolume": "common",

"containerPath": "/opt/ecs/common/",

"readOnly": true

}

],

"volumesFrom": [],

"linuxParameters": {

"initProcessEnabled": true

},

"stopTimeout": 150,

"logConfiguration": {

"logDriver": "awsfirelens",

"options": {

"Name": "firelens",

"config-file-type": "file",

"config-file-value": "/fluent-bit/config/fluent-bit.conf"

}

},

"systemControls": []

},

{

"name": "log_router",

"image": "{커스텀한 fluent-bit 이미지}",

"cpu": 0,

"memoryReservation": 50,

"portMappings": [],

"essential": true,

"environment": [

{

"name": "BUCKT_NAME",

"value": "test"

},

{

"name": "SERVICE_NAME",

"value": "python-test"

}

],

"mountPoints": [],

"volumesFrom": [],

"user": "0",

"systemControls": [],

"firelensConfiguration": {

"type": "fluentbit",

"options": {

"enable-ecs-log-metadata": "false"

}

}

}

3.2. S3 방법

S3 방법은 간단하게 conf파일을 S3에 두고 fluent-bit 컨테이너가 프로비저닝 시에 해당 S3에 있는 conf를 참조 하는 방법이다. conf 파일 내용은 상기에 나와 있으니 생략한다.

예를 들면 test라는 버킷 하위에 fluent-bit.conf 파일이 존재한다면 작업정의는 아래와 같다.

"logConfiguration": {

"logDriver": "awsfirelens",

"options": {

"Name": "firelens",

"config-file-type": "s3",

"config-file-value": "arn:aws:s3:::test/fluent-bit.conf"

}

}

전체 작업정의

{

"name": "python-test",

"image": "테스트 이미지",

"cpu": 0,

"memory": 2048,

"portMappings": [

{

"containerPort": 8080,

"hostPort": 0,

"protocol": "tcp"

}

],

"essential": true,

"environment": [

{

"name": "TG_ARN",

"value": "타겟그룹 ARN"

}

],

"mountPoints": [

{

"sourceVolume": "common",

"containerPath": "/opt/ecs/common/",

"readOnly": true

}

],

"volumesFrom": [],

"linuxParameters": {

"initProcessEnabled": true

},

"stopTimeout": 150,

"logConfiguration": {

"logDriver": "awsfirelens",

"options": {

"Name": "firelens",

"config-file-type": "s3",

"config-file-value": "arn:aws:s3:::test/fluent-bit.conf"

}

},

"systemControls": []

},

{

"name": "log_router",

"image": "{커스텀한 fluent-bit 이미지든 AWS에서 제공하는 이미지 상관 없음}",

"cpu": 0,

"memoryReservation": 50,

"portMappings": [],

"essential": true,

"environment": [

{

"name": "BUCKT_NAME",

"value": "test"

},

{

"name": "SERVICE_NAME",

"value": "python-test"

}

],

"mountPoints": [],

"volumesFrom": [],

"user": "0",

"systemControls": [],

"firelensConfiguration": {

"type": "fluentbit",

"options": {

"enable-ecs-log-metadata": "false"

}

}

}

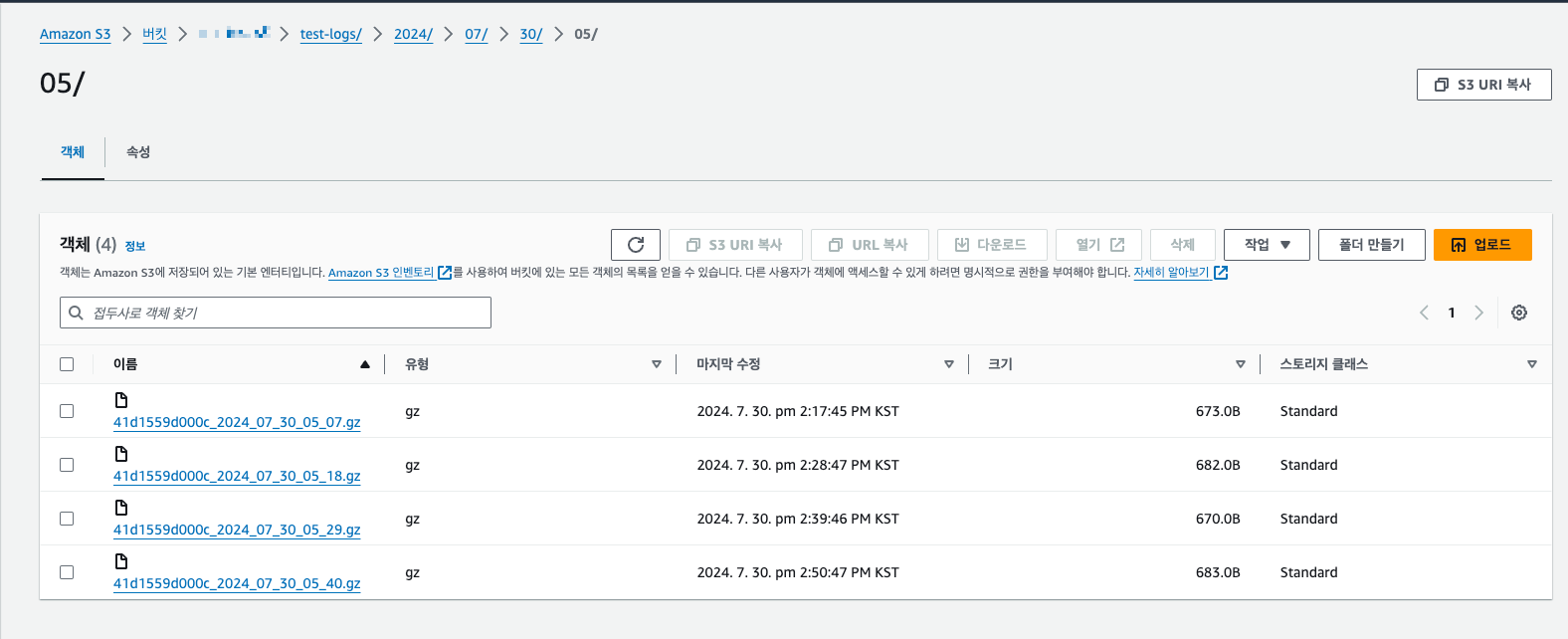

로그 적재 확인

gz파일로 압축후에 문제 없이 S3로 저장되는걸 확인 할 수 있으며 특이사항으로는 fluent-bit 컨테이너의 time이 kst인데 로그 적재시 format은 UTC이며 현재 kst로 변경하는 방법은 없으며 gitbhub에서 인지하고 있음.

적재된 gz파일을 콘솔에서 다운로드 받으면 바로 압축이 풀리게된다. 압축이 풀려도 확장자는 gz(해당부분도 현재 동일하게 발생하는것 같다.)

참고

https://docs.fluentbit.io/manual/pipeline/outputs/s3

Amazon S3 | Fluent Bit: Official Manual

Send logs, data, metrics to Amazon S3

docs.fluentbit.io

https://docs.aws.amazon.com/ko_kr/AmazonECS/latest/developerguide/firelens-taskdef.html

Amazon ECS 태스크 정의 예제: 로그를 FireLens로 라우팅 - Amazon Elastic Container Service

사용자 정의 구성 파일을 사용할 때는 FireLens가 사용하는 경로가 아닌 다른 경로를 지정해야 합니다. Amazon ECS는 Fluent Bit의 경우 /fluent-bit/etc/fluent-bit.conf 파일 경로를, Fluentd의 경우 /fluentd/etc/fluent

docs.aws.amazon.com

https://github.com/aws-samples/amazon-ecs-firelens-examples/tree/mainline/examples/fluent-bit/s3

amazon-ecs-firelens-examples/examples/fluent-bit/s3 at mainline · aws-samples/amazon-ecs-firelens-examples

Sample logging architectures for FireLens on Amazon ECS and AWS Fargate. - aws-samples/amazon-ecs-firelens-examples

github.com

https://github.com/aws/aws-for-fluent-bit/issues/432

How to set timezone in fluent bit S3 plugin? · Issue #432 · aws/aws-for-fluent-bit

As the title.

github.com

https://github.com/fluent/fluent-bit/issues/3676

S3 Output Compression not working · Issue #3676 · fluent/fluent-bit

Bug Report Describe the bug Using td-agent-bit version 1.7.8 with the S3 output, the compression setting seems to be ignored, even when using use_put_object true To Reproduce Here is my configurati...

github.com

'DevOps > AWS' 카테고리의 다른 글

| [AWS] RDS 인스턴스, Aurora RDS audit로그 활성화 (0) | 2024.09.01 |

|---|---|

| [AWS] 인스턴스의 버스트기능(번역) (2) | 2023.03.02 |

| [자격증 후기] AWS SAA-C03 솔루션즈 아키텍트 어소시에이트 합격후기(2023-02-27) (4) | 2023.02.27 |

| [AWS] SAM으로 API Gateway와 lambda, dynamoDB 배포 (0) | 2023.02.03 |

| [AWS] GitHub Actions로 AWS ECS 배포 자동화 하기 (0) | 2023.01.20 |

![[AWS] ECS에서 firelens를 이용한 컨테이너 로그 아카이빙](https://img1.daumcdn.net/thumb/R750x0/?scode=mtistory2&fname=https%3A%2F%2Fblog.kakaocdn.net%2Fdn%2Fw8P1t%2FbtsJn8M4wBd%2FGgRwGwUFn1klLdr4tea2ik%2Fimg.png)